Nous expliquons et résumons l’histoire de l’ordinateur, comment ont été inventés les premiers et quelles sont ses principales caractéristiques.

Historique de l’ordinateur

L’histoire de l’ordinateur est le récit des événements, des innovations et des développements technologiques dans le domaine de l’ informatique et de l’automatisation, qui ont donné naissance aux machines que nous connaissons sous le nom d’ordinateurs, d’ordinateurs ou d’ordinateurs. Il enregistre également son amélioration et sa mise à jour jusqu’à atteindre les versions miniaturisées et rapides du 21e siècle.

Les ordinateurs, comme nous le savons tous , sont les machines à calculer les plus avancées et les plus efficaces inventées par l’ être humain . Ils sont dotés d’une puissance de fonctionnement, d’une autonomie et d’une rapidité suffisantes pour vous remplacer dans de nombreuses tâches, ou vous permettre une dynamique de travail virtuelle et numérique qui n’a jamais été possible auparavant dans l’histoire.

L’invention de ce type d’appareil au XXe siècle a révolutionné à jamais notre façon de comprendre les processus industriels , le travail , la société et d’innombrables autres domaines de notre vie. Cela affecte de la manière même d’être en relation les uns avec les autres, jusqu’au type d’opérations d’échange d’informations à l’échelle mondiale que nous sommes capables de mener.

Voir aussi : Microprocesseur

fond d’ordinateur

L’histoire de l’ordinateur est longue, remontant aux premières règles à calcul et aux premières machines conçues pour faciliter la tâche d’arithmétique aux humains. L’abaque, par exemple, a été une avancée importante en la matière, créé vers 4 000 av. c.

Il y eut aussi des inventions beaucoup plus tardives, comme la machine de Blaise Pascal , dite Machine de Pascal ou Pascalina, créée en 1642. Elle consistait en une série d’engrenages qui permettaient d’effectuer des opérations arithmétiques. Cette machine a été améliorée par Gottfried Leibinitz en 1671 et l’histoire des calculatrices a commencé.

Les tentatives humaines d’automatisation se sont poursuivies depuis : Joseph Marie Jacquard inventa un système de cartes perforées en 1802 pour tenter d’automatiser ses métiers à tisser, et en 1822 l’Anglais Charles Babbage utilisa ces cartes pour créer une machine à calculer différentielle.

Seulement douze ans plus tard (1834), il parvient à innover sa machine et à obtenir une machine analytique capable des quatre opérations arithmétiques et de stocker des nombres en mémoire (jusqu’à 1 000 nombres à 50 chiffres). Pour cette raison, Babbage est considéré comme le père de l’informatique , car cette machine représente un saut dans le monde de l’informatique tel que nous le connaissons.

invention informatique

L’invention de l’ordinateur ne peut être attribuée à une seule personne . Babbage est considéré comme le père de la branche du savoir qui sera plus tard l’informatique, mais ce n’est que bien plus tard que le premier ordinateur sera réalisé en tant que tel.

Un autre fondateur important de ce processus fut Alan Turing , créateur d’une machine capable de tout calculer, qu’il appela la « machine universelle » ou « machine de Turing ». Les idées qui ont servi à le construire étaient les mêmes qui ont ensuite donné naissance au premier ordinateur.

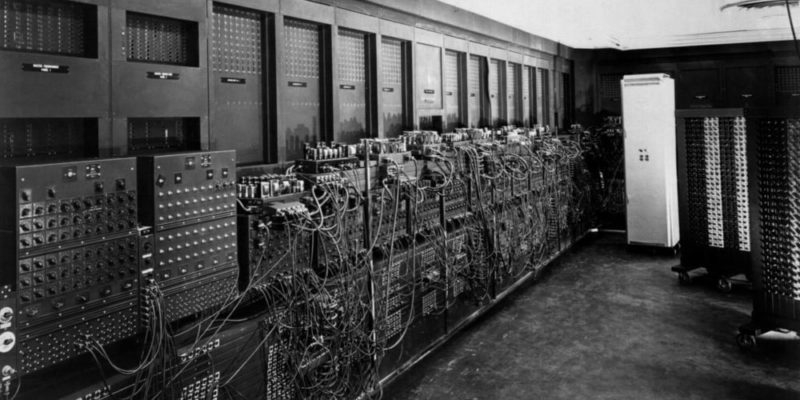

Un autre cas important était celui de l’ ENIAC ( Electronic Numeral Integrator and Calculator , c’est-à-dire Numeral Electronic Integrator and Calculator), créé par deux professeurs de l’Université de Pennsylvanie en 1943, considéré comme le grand-père des ordinateurs proprement dits. Il se composait de 18 000 tubes à vide qui remplissaient une pièce entière.

invention des transistors

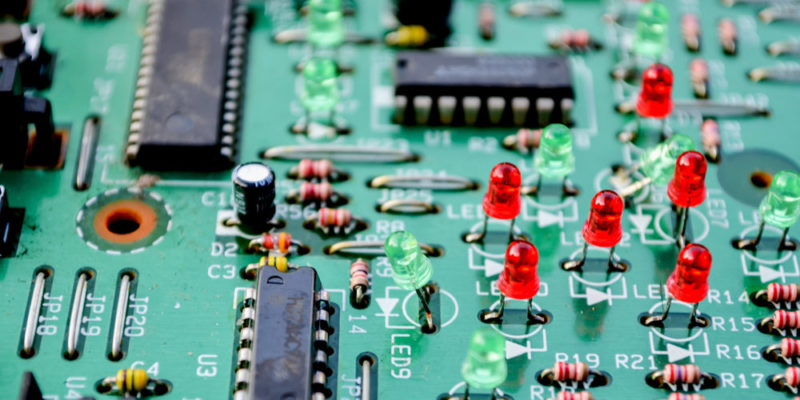

L’histoire des ordinateurs n’aurait pas eu le cours qu’elle a eu sans l’invention des transistors en 1947, fruit des efforts des laboratoires Bell aux États-Unis . Ces appareils sont des interrupteurs électriques en matériaux solides et ne nécessitant pas de vide.

Cette découverte a été essentielle pour la fabrication des premières micropuces et a permis le passage des appareils électriques aux appareils électroniques. Les premiers circuits intégrés (c’est-à-dire les puces) sont apparus en 1958, résultat des efforts de Jack Kilby et Robert Noyce. Le premier a reçu le prix Nobel de physique en 2000 pour cette découverte.

Continuer sur : Transistors

le premier ordinateur

Les premiers ordinateurs sont apparus comme des machines de calcul logique , en raison des besoins des alliés pendant la Seconde Guerre mondiale . Pour décoder les transmissions des parties belligérantes, des calculs devaient être effectués rapidement et constamment.

Pour cette raison, l’université de Harvard a conçu le premier ordinateur électromécanique en 1944 , avec l’aide d’IBM, nommé Mark I. Il mesurait environ 15 mètres de long et 2,5 mètres de haut, enveloppé dans un boîtier en verre et en acier inoxydable . Il comptait 760 000 pièces, 800 kilomètres de câbles et 420 interrupteurs de commande. Il a servi pendant 16 ans.

Dans le même temps, en Allemagne , les Z1 et Z2 avaient été développés , des modèles de test d’ordinateurs similaires construits par Konrad Zuse, qui acheva son modèle Z3 entièrement opérationnel, basé sur le système binaire. Il était plus petit et moins cher à construire que son concurrent américain.

Le premier ordinateur à usage commercial

En février 1951, le Ferranti Mark 1 est apparu , une version moderne de l’ordinateur nord-américain du même nom qui était disponible dans le commerce. Il était extrêmement important dans l’histoire de l’ordinateur, car il disposait d’un index d’enregistrements, ce qui facilitait la lecture d’un ensemble de mots en mémoire.

Pour cette raison, jusqu’à trente-quatre brevets différents ont émergé de son développement. Plus tard, il a servi de base à la construction d’ordinateurs IBM , très réussis industriellement et commercialement.

Le premier langage de programmation

En 1953, FORTRAN est apparu , un acronyme pour The IBM Mathematical Formula Translation (« IBM Mathematical Formula Translation »), développé comme le premier langage de programmation formel, c’est-à-dire le premier programme conçu pour fabriquer des programmes informatiques, par des programmeurs IBM, dirigé par John Backus.

Initialement, il a été développé pour l’ordinateur IBM 704 et pour une large gamme d’applications scientifiques et d’ingénierie, c’est pourquoi il a eu une large série de versions sur un demi-siècle de mise en œuvre. C’est toujours l’un des deux langages de programmation les plus populaires, en particulier pour les supercalculateurs du monde.

Le premier ordinateur moderne

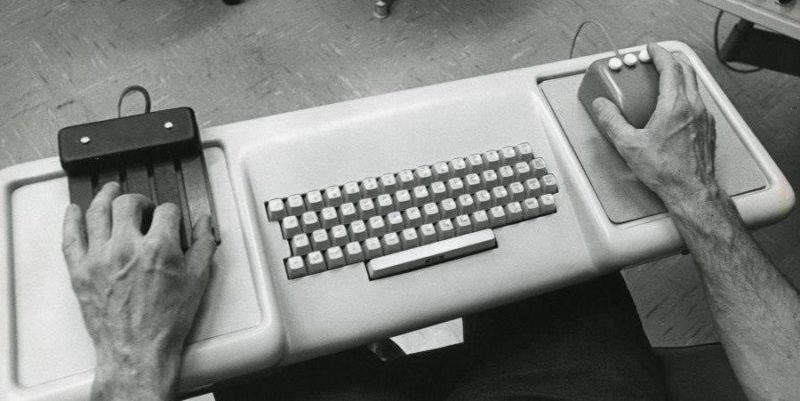

Le premier ordinateur moderne est apparu à l’automne 1968, sous la forme d’un prototype présenté par Douglas Engelbart. Pour la première fois, il disposait d’une souris, ou d’un pointeur, et d’une interface utilisateur graphique (GUI), changeant à jamais la façon dont les utilisateurs et les systèmes informatiques interagissaient désormais.

La présentation du prototype d’Engelbart a duré 90 minutes et comprenait une connexion écran avec son centre de recherche , constituant ainsi la première visioconférence de l’histoire. Les modèles Apple et Windows ultérieurs étaient des versions ultérieures de ce premier prototype.

Périphériques de stockage secondaires

Le premier dispositif d’échange d’informations d’un ordinateur à un autre fut les disquettes, créées en 1971 par IBM . Il s’agissait de carrés noirs de plastique souple , au milieu desquels se trouvait un matériau magnétisable qui permettait d’enregistrer et de récupérer des informations. Il existait plusieurs types de disquettes :

- 8 pouces. Le premier à apparaître, volumineux et d’une capacité comprise entre 79 et 512 ko.

- 5 ¼ pouces. Semblables aux 8 pouces mais plus petits, ils stockent entre 89 et 360 ko.

- 3 ½ pouces. Introduits dans les années 1980, ils étaient rigides, colorés et beaucoup plus petits, avec une capacité comprise entre 720 et 1 440 ko.

Il existait également des versions haute et basse densité et de nombreuses variantes de cassettes. A la fin des années 80, l’apparition et la masse du disque compact (CD) ont complètement remplacé le format, augmentant la vitesse et la capacité de récupération des données.

Enfin, au tournant du siècle, tous ces formats d’appareils sont devenus obsolètes et ont été remplacés par la clé USB ou la mémoire flash amovible , de capacité variée (mais bien supérieure), à grande vitesse et à l’extrême portabilité.

Les premiers réseaux informatiques

Le premier réseau informatique au monde était ARPANET, créé en 1968 par le Département de la Défense des États-Unis. Il a servi de plate-forme rapide pour l’échange d’informations entre les institutions éducatives et étatiques, probablement à des fins militaires.

Ce réseau s’est développé, mis à jour, et est finalement devenu l’épine dorsale d’ Internet , déjà ouvert au grand public, au moins jusqu’en 1990.

Ordinateurs du 21ème siècle

Les ordinateurs font aujourd’hui partie de la vie quotidienne , à tel point que pour beaucoup, il est déjà inconcevable un monde sans eux. On les retrouve dans nos bureaux, sur nos téléphones portables , dans divers appareils électroménagers, en charge d’installations automatisées, et effectuant des opérations interminables de manière automatique et autonome.

Cela a de nombreux aspects positifs, mais cela s’accompagne également de nombreuses craintes . Par exemple, l’essor de la robotique, une prochaine étape naturelle pour l’informatique, promet de mettre de nombreux travailleurs humains au chômage, dépassés par la capacité à automatiser de plus en plus rapidement.